阿米巴 CEO 分享:生成式 AI 的 16 条产业趋势

阿米巴资本 · 2024-04-01 15:02:41 · 热度:加载中...

著名风投公司 Andreessen Horowitz 近期发布了一份研究报告,标题为《16 Changes to the Way Enterprises Are Building and Buying Generative AI》

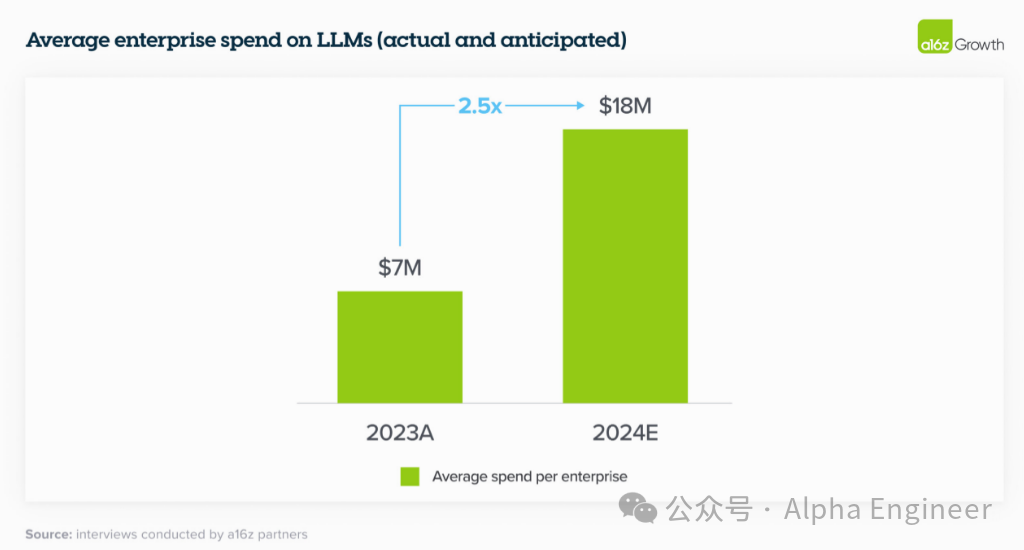

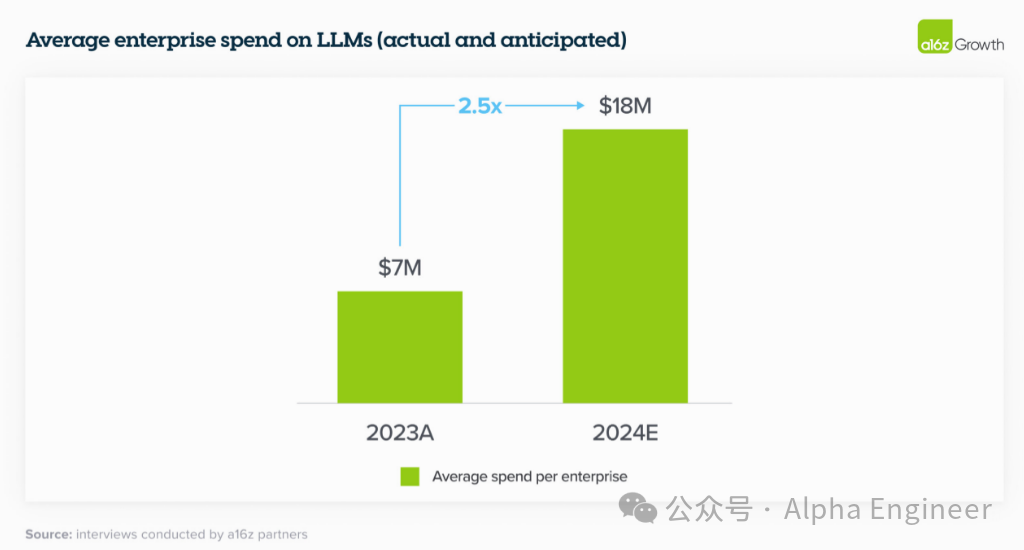

为了撰写这份报告,a16z 的分析师采访了近百名世界五百强企业领袖,了解他们对于生成式 AI 技术的展望、应用落地规划、采购预算制定、开闭源模型偏好等关键问题的态度与选择。最终,a16z 总结出了 16 个言简意赅的结论。下面我给大家解读一下这篇报告,报告链接放在文末,感兴趣的朋友可以去看原文。▋ 趋势 1:2024 年生成式 AI 相关预算翻三番2023 年受访企业在大模型上的平均投入在 700 万美金,这个数字在 2024 年提升至 1,800 万美金,提升了 2.5 倍。

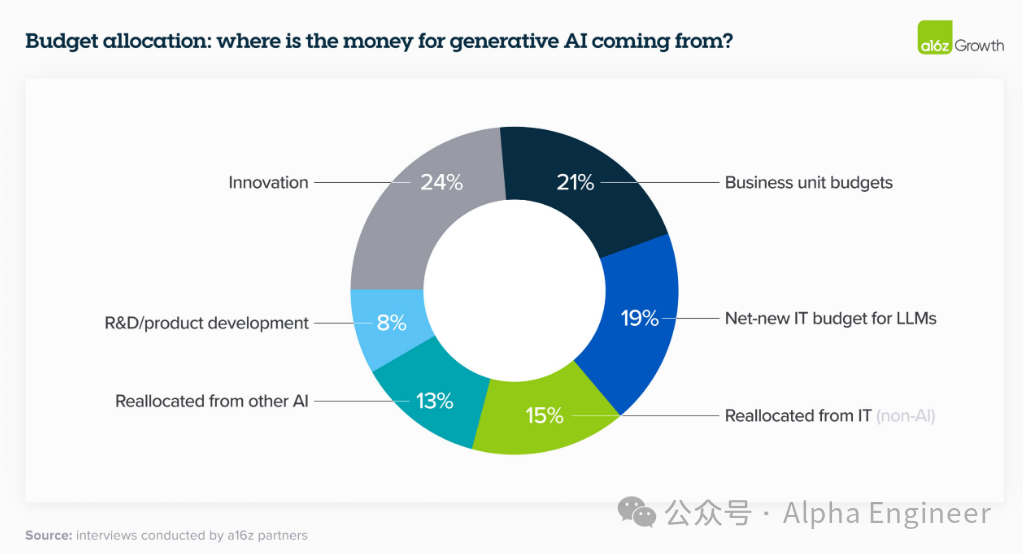

▋ 趋势 2:生成式 AI 的采购预算,从「创新项目」预算池调整到「软件服务采购」预算池

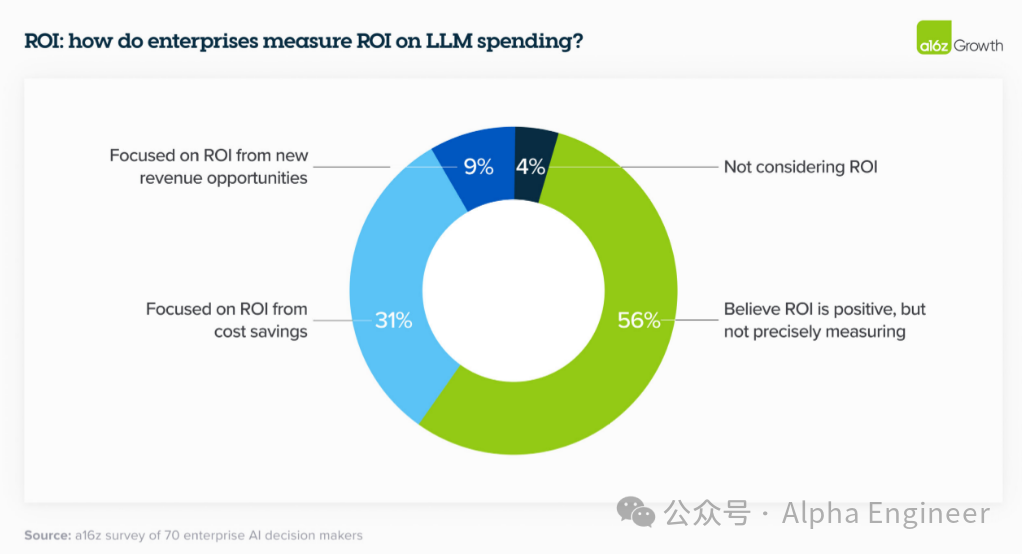

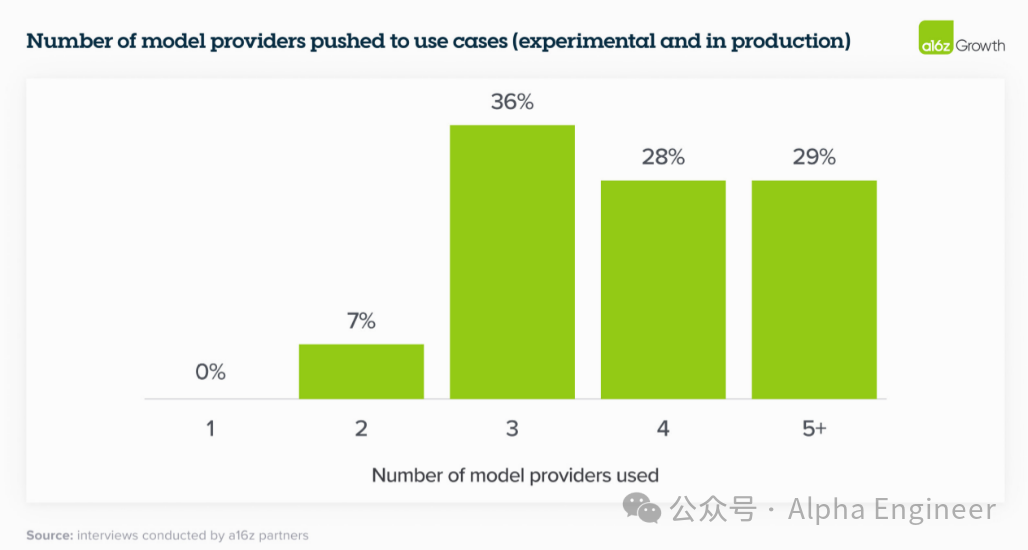

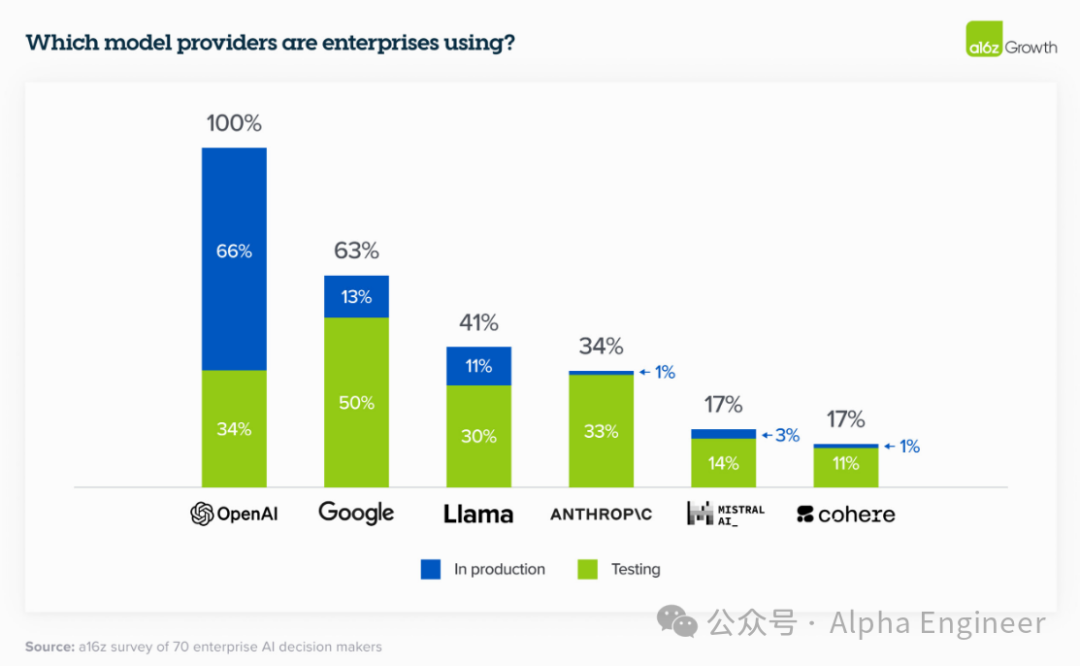

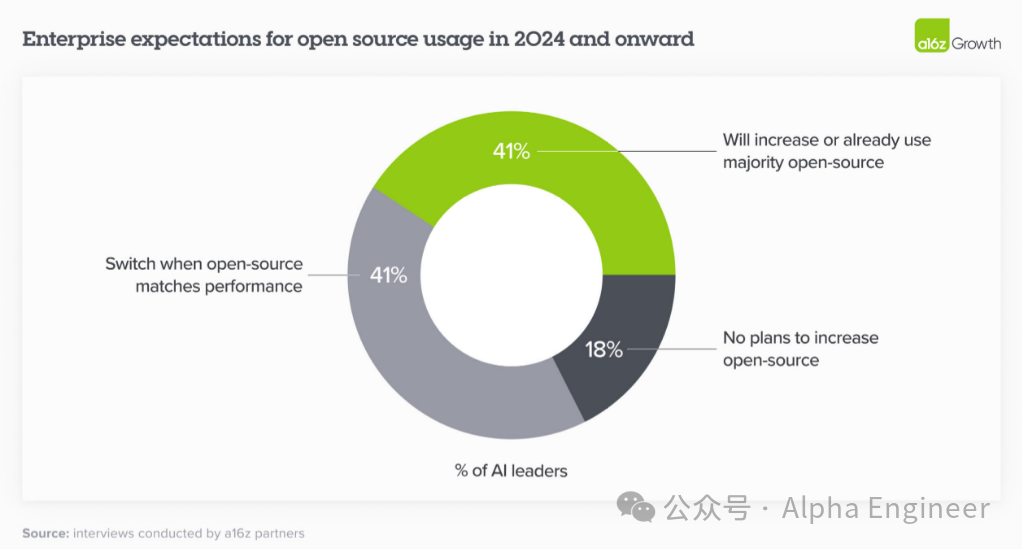

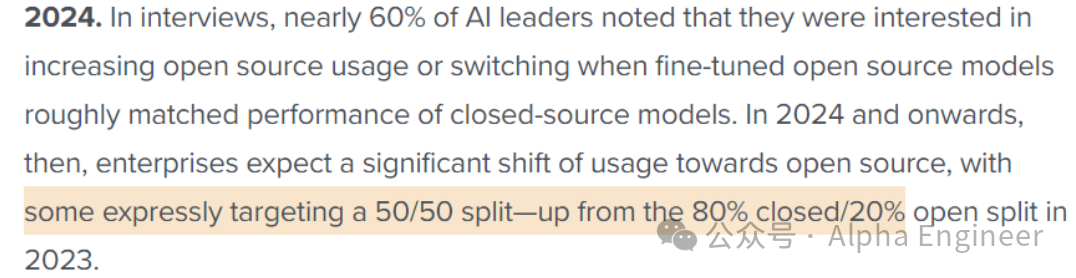

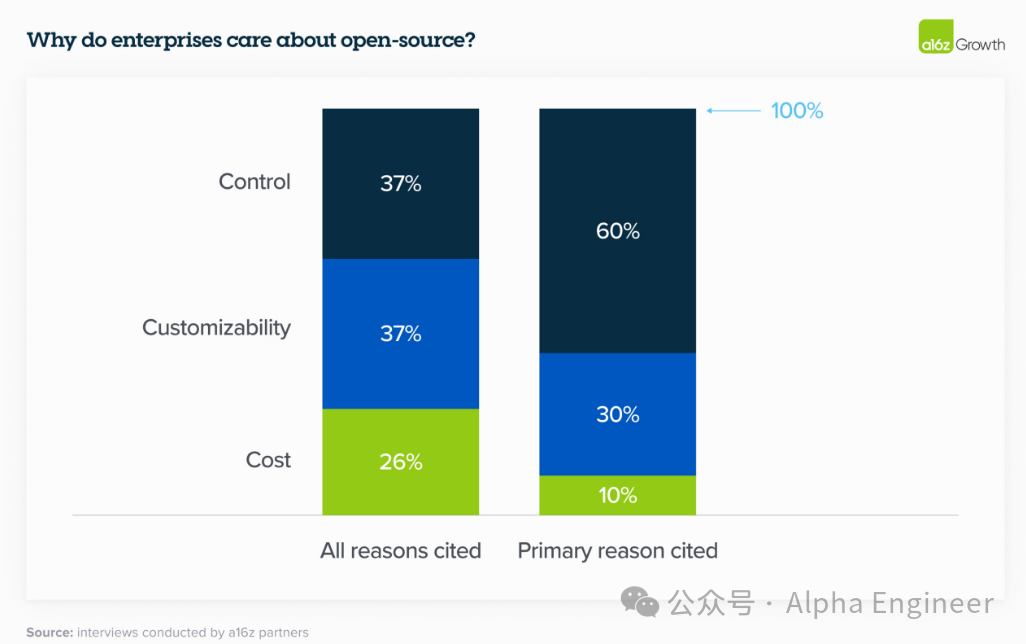

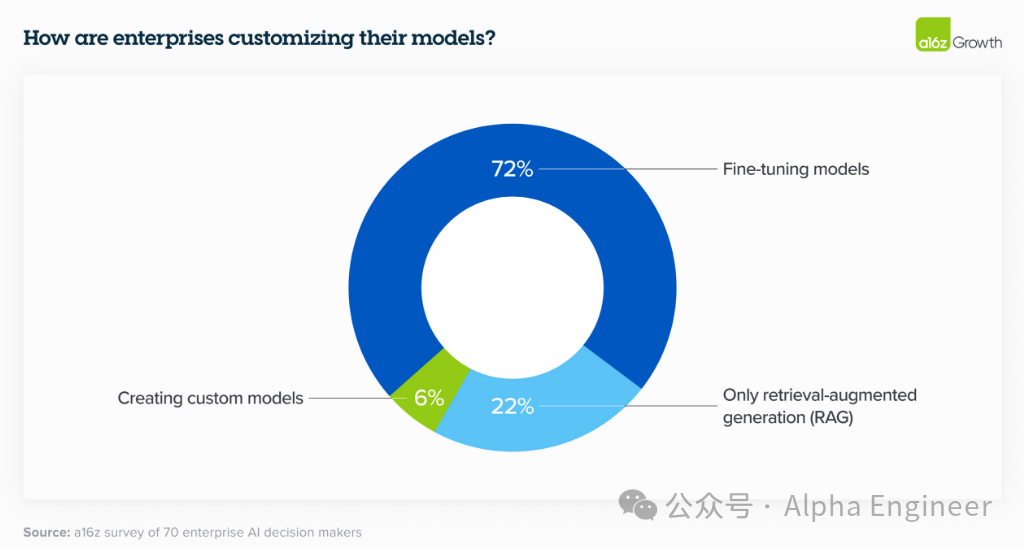

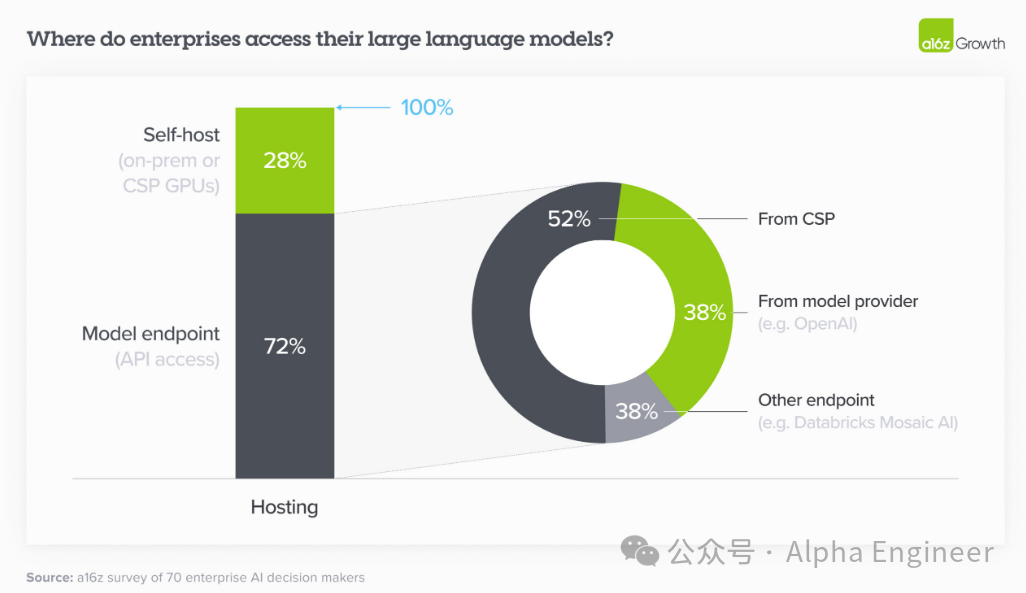

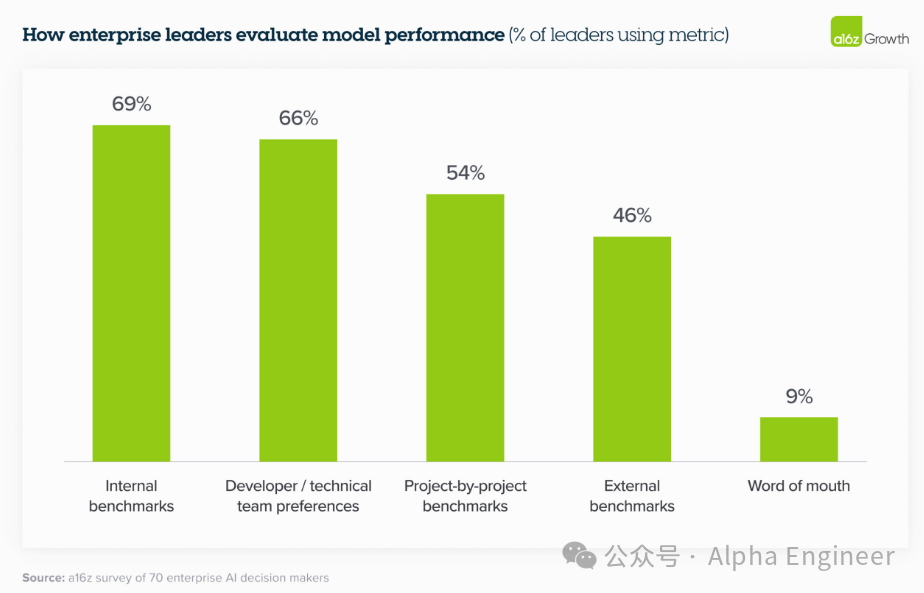

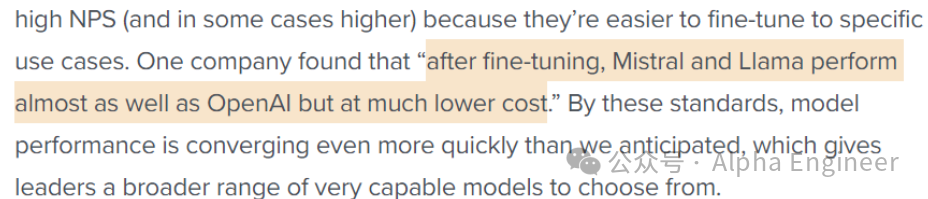

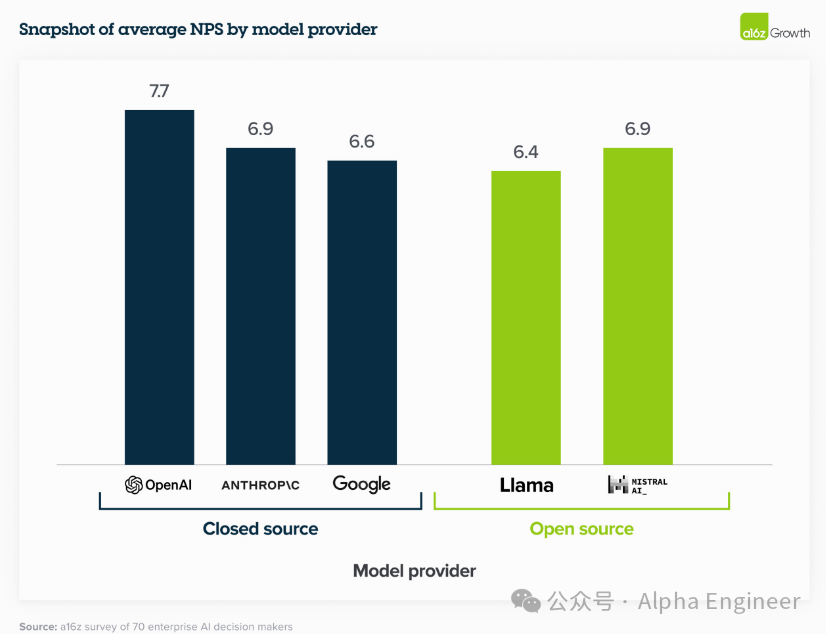

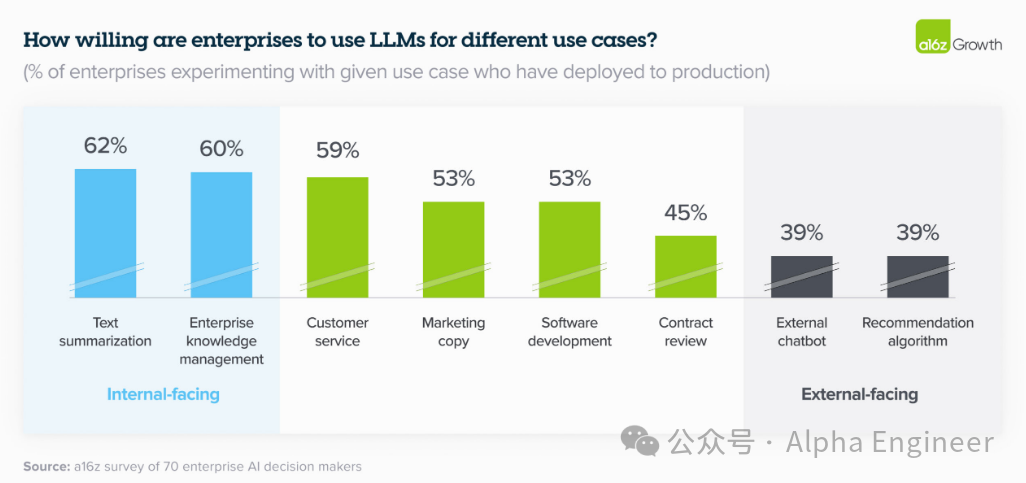

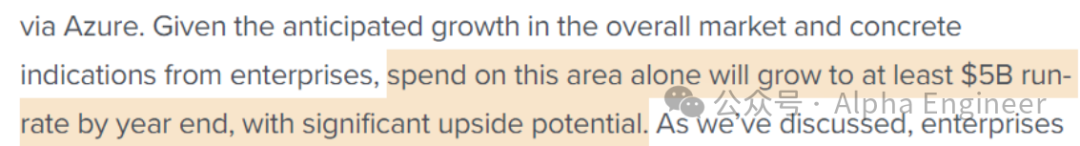

23 年不少企业对于生成式 AI 的采购预算来自于“创新项目”预算池,这种预算往往是一次性的。但是 24 年企业主对于生成式 AI 的采购预算更多调整到“软件服务采购”的预算池,这类预算更具持续性,且规模更大。有个别受访企业表示,已经将 AI 的采购预算与 headcount 节省直接挂钩,尤其是在客服领域。通过使用 LLM来 支持客服工作,每次客服呼叫可以节省 6 美金,这占到总服务成本的 90%。为了测算 AI 投入的回报,企业主在积极寻找有效的 ROI 指标。常用的指标包括生产效率的提升、人力成本的节省、客户满意度的提升(如 NPS)。但不同场景领域中,有效的 ROI 指标各不相同,仍需积极探索。未来AI采购的依据将从「信仰驱动」转向「ROI驱动」。▋ 趋势 4:大多数企业内部缺少 AI 人才,AI 部署及微调服务成为刚需大模型采购只是万里长征的第一步。如何在企业内部有效部署,基于企业内部数据进行微调训练,并结合实际业务场景有效落地,才是最关键的。一位受访企业表示,LLM 的采购预算相比构建 AI 应用案例的成本而言,是小巫见大巫了。同时,由于生成式 AI 的浪潮来得迅猛,多数企业内部紧缺 AI 相关人才。因此,如何更好的帮助企业部署落地 LLM,并且形成卓有成效的应用案例,成为了大模型公司的兵家必争之地。为了让大模型成为真正有效的生产力工具而非玩具,「最后一公里」显得格外重要。6 个月前,绝大部分企业只在使用 OpenAI 一家的模型。但今年企业基本都在同时测试及使用多个大模型。这一方面是因为大模型行业发展节奏太快,leaderboard 榜单变化频繁。另一方面也是为了避免绑定在一家供应商的模型之上,形成业务锁死。绝大部分受访企业表示,会同时部署 SOTA 的闭源大模型,以及开源大模型,以期获得最佳的业务体验。虽然 23 年 80-90% 的大模型市场份额归属于闭源大模型提供商,但有接近 60% 的受访者表达了对于开源大模型的强烈兴趣。只要开源大模型经过微调后的性能表现能够与闭源大模型基本接近,企业往往会选择部署开源大模型。a16z 预测,24 年基于开源大模型的相关采购部署会成为主流趋势,与闭源大模型形成 5/5 开的局面。▋ 趋势 7:相比成本而言,安全可控及个性化定制是首要条件在企业采购 LLM 的标准中,私有数据的「安全可控」,以及针对自身应用场景的「个性化定制」,成为重要的考量标准。相比之下,成本并不那么关键。这可能是因为大家已经形成一种共识,即 LLM 为企业带来的经济价值,将远远超过其采购成本。出于安全及合规考虑,企业往往不愿意将私域数据传输到闭源大模型提供商。因此,部分企业选择自己部署开源大模型。另一些企业倾向于选择那些提供 VPC 集成能力的大模型提供商。▋ 趋势 9:相比从零开始训练大模型,企业更偏好采用微调及 RAG 的方式23年 BloombergGPT 掀起过一整热潮,但当潮水退去后,人们发现在企业内部从零开始训练一个大模型并非明智之举。随着开源大模型的能力水涨船高,更多企业选择采用微调以及 RAG 的方式,外挂一个向量数据库,来满足内部的应用需求。▋ 趋势 10:在大模型采购的选择中,云服务商是一个关键变量绝大多数企业选择通过它们现有的云服务商来购买大模型服务。比如 Azure 的客户更偏好 OpenAI,而 Amazon 的客户更偏好 Anthropic 以及 Cohere。这一方面是因为企业主对于闭源大模型厂商的信任低于对 CSP 的信任。另一方面也是为了规避冗长的采购流程。▋ 趋势 11:大模型的差异化特征成为影响采购决策的关键相比于可靠性、推理能力等评估 LLM 的传统指标,企业方更关注大模型的特色能力。比如有一家企业就是因为 Anthropic 能提供 200K 的超长 Context Window 而选择了它。另有一家企业因为需要快速微调能力而选择了 Cohere。▋ 趋势 12:大部分企业主认为大模型的能力在趋同外界对于大模型能力的评估主要依据公开的 benchmark,但是企业方对大模型能力的评估更多的会参考内部的专业 benchmark。一家受访企业表示,经过微调后,Mistral 和 Llama 的表现与 OpenAI 趋同,且成本更低。为了避免锁定于一家大模型供应商,企业往往会构建自己的「模型花园」,并将应用构建于模型花园之上。这样一来,企业方会有更多的选择,切换成本大幅降低。▋ 趋势 14:套壳软件难以为继,真正结合业务流程的 AI 应用有非常广阔的市场空间由于大模型 API 服务变得越来越方便调用,未来 GPT 套壳软件的生存空间将被大幅压缩。未来,真正有着产业价值的大模型应用,肯定不是单纯的「LLM+UI」的万能公式,而是真正扎根于产业,与业务流程高度结合的 AI 应用。▋ 趋势 15:大模型应用案例更多聚焦于对内,而非对外直接服务由于大模型仍然存在幻觉现象,目前大模型的产业应用更多聚焦于服务企业内部,而非直接对客。尤其在金融和医疗领域,一旦出现错误的回答,可能会给用户带来经济损失,或者影响其身体健康。因此现阶段的服务方式,更多是在大模型和终端用户之间,安插一个真人,以人作为媒介对外提供服务。▋ 趋势 16:大模型 API 及微调服务市场规模有望快速增长根据统计,23 年全球大模型 API 及微调服务的市场规模约 15-20 亿美金,这个数字在 24 年预计会增长到 50 亿美金。

(文毕)

原文链接:https://a16z.com/generative-ai-enterprise-2024/

原文也可以在 AlphaEngine 中查看:

PC端可以登录:https://www.alphaengine.top/

小程序版可以点击:AlphaEngine

文章仅代表作者观点,版权归原作者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,对文中观点保持中立,对所包含内容的准确性、可靠性或完整性不提供任何明示或暗示的保证,不对文章观点负责,仅作分享之用。如分享内容、图片侵犯您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@qimingpian.com。